Cet article relate la mise en œuvre d'un réseau Wi-Fi sécurisé et monitoré du type de ce que l'on peut trouver dans une société commerciale, une université ou une association. Pour un point d'accès Wi-Fi ouvert à domicile, je recommande plutôt cet excellent tutoriel : Mise en place d'un réseau Wi-Fi ouvert - Emile (iMil) Heitor.

Même si cette mise en œuvre se situe dans un cadre scolaire (« bouh c'est nul, on ne fait pas comme ça en vrai ! » diront certains), je pense qu'elle vaut la peine d'être partagée et d'être lue car les technos étudiées (RADIUS, 802.1X, radvd/dhcpv6, etc.) sont intéressantes et que les problématiques posées sont celles que l'on rencontre dans de vrais déploiements : RADIUS, limites de l'accounting RADIUS dans un réseau Wi-Fi 802.1X, problématiques légales autour des données de connexion, cohabitation entre SLAAC et DHCPv6, etc.

Ce travail a été réalisé avec Hamza Hmama.

Ce travail datant d'il y a 3 ans, je l'ai actualisé avant publication, quand j'ai estimé que c'était nécessaire. Par exemple, des situations ont évolué (comme umip), j'ai un peu de recul, etc.

Je remercie Christian pour le prêt longue durée d'un WRT54GL. 🙂 Merci à bcollet pour le don d'un Cisco Aironet 1120B. 🙂

Table des matières

- Table des matières

- Énoncé

- Choix

- Architecture déployée

- Données de connexion

- Page d'administration

- Mobilité IPv6

- Mise en œuvre

- Configurer un point d'accès Cisco Aironet 1120B

- Configurer un point d'accès Linksys WRT54GL avec OpenWRT

- Installer un système Debian GNU/Linux sur une clé USB bootable

- Configuration de base de la passerelle

- Tester

- Authentification 802.1X

- PepperSpot

- Données de connexion

- Accounting RADIUS

- Sur un point d'accès Cisco Aironet 1120B

- Sur un point d'accès WRT54GL avec OpenWRT

- Actualisation fréquente…

- … et disparition subite d'un client Wi-Fi

- Comment ajouter un attribut de réponse dans une réponse RADIUS ?

- Attributs de réponse et subtilité EAP-TTLS

- Stockage de l'IPv6 des tickets d'accounting

- Ménage régulier

- Outro

- Logs DHCP

- Journaliser les associations MAC<->IP

- Accounting RADIUS

- Administration, supervision, types de flux

- Mobilité IPv6

- Démonstrations

Énoncé

Malheureusement, j'ai jeté l'énoncé à la poubelle lors d'un déménagement et je n'en ai pas gardé une copie numérique. Mais, en gros, il nous a été demandé de :

- Mettre en place un hotspot Wi-Fi avec une authentification UAM (un portail captif, quoi) et une authentification 802.1X, similaire aux réseaux Wi-Fi universitaire OSIRIS et OSIRIS-sec déployés par la direction informatique de l'université sur tout le campus ;

- Chaque client Wi-Fi doit avoir une connectivité IPv4 et IPv6 ;

- Produire des logs et mettre en place une solution de supervision qui fait remonter des informations pertinentes (état de la machine passerelle, état des liaisons, trafic, types de trafic, etc.) ;

- Aucune solution de filtrage (de sites web, de ports, de noms de domaine,…) ou de traçabilité (qui a consulté telle ressource à telle heure) n'a été demandée. En conséquence, nous n'avons installé aucun serveur proxy ou autres outils ;

- Configurer un mobile node IPv6 sur une machine cliente de notre point d'accès Wi-Fi ;

- Nous verrons tout au long de cet article que des consignes et des recommandations informelles ont été ajoutées par le prof' tout au long de ce TP.

Ce sujet est celui de Thomas Noël, de l'université de Strasbourg, dans le cadre du cours « Mobilité et réseaux sans fil ».

Choix

Panorama des choix que nous avons faits.

Machine routeur / passerelle

Il s'agit de la machine qui fait la jonction entre le réseau filaire et les réseaux sans fil et sur laquelle nous allons installer le portail captif, le serveur RADIUS, stocker les données de connexion, etc.

Afin de pouvoir avancer ce projet durant les vacances universitaires de Toussaint, d'être indépendants des séances de TP et de la disponibilité de la salle de TP, nous avons fait le choix de travailler avec l'un de nos ordinateurs personnels. Il s'agit d'un ordinateur portable standard. Le handicap principal est qu'il est équipé d'une seule prise réseau, nous y reviendrons.

Comme il était hors de question de reformater cet ordinateur pour créer une partition dédiée à ce projet (manque d'espace), ou d'installer tout et n'importe quoi sur notre système stable que nous utilisons au quotidien, ou d'utiliser la virtualisation qui peut parfois se montrer pénible lorsqu'il s'agit de prolonger des VLANs à l'intérieur de la machine virtuelle, nous avons décidé d'installer un système GNU/Linux Debian testing dédié à ce projet sur une clé USB bootable.

Point d'accès Wi-Fi / AP

Là aussi, afin de pouvoir avancer ce projet durant les vacances universitaires de Toussaint, d'être indépendants des séances de TP et de la disponibilité de la salle de TP (dans laquelle étaient stockées les AP 😉 ) et des points d'accès Wi-Fi eux-mêmes, nous avons dû chercher un moyen de nous émanciper des bornes Cisco fournies par l'université.

Dans un premier temps, nous avons utilisé hostapd, un logiciel libre qui permet la création de points d'accès Wi-Fi (en mode infrastructure) sur un ordinateur équipé d'une carte réseau compatible. Nous avons passé du temps à mettre en place un SSID sécurisé (802.1X) fonctionnel avant de nous rendre compte que la carte réseau Wi-Fi (une Atheros AR9285 😉 ) de notre machine personnelle supporte la création d'un seul SSID tout au plus en simultané.

Note : si les drivers sont compatibles, il est possible de savoir combien de SSID une carte réseau peut gérer dans tel mode en utilisant la commande « iw list » et en regardant « Supported interface modes » et « valid interface combinations » dans la sortie. Pour les tutoriels qui vont bien, voir : création d'un point d'accès Wi-Fi sur son ordinateur avec hostapd dans la doc' Ubuntu et Multiple SSIDs with hostapd.

Finalement, notre choix s'est porté sur un point d'accès Cisco Aironet 1120B de récupération. Bien que ce modèle présente quelques limitations (802.11b uniquement, pas de support de WPA2 ni de CCMP, notamment), il est amplement suffisant pour mener à bien ce projet universitaire.

Portail captif

Avant de rechercher les différents portails captifs existants, nous avons établi les critères d'évaluation et de comparaison suivants (du plus important au moins important) :

- Il doit être libre et gratuit ;

- Il doit être basé sur GNU/Linux ou *BSD ou être un logiciel qui fonctionne sur un système d'exploitation faisant partie de ces deux familles ;

- Il doit gérer IPv6 avec les mêmes fonctionnalités qu'IPv4 et notamment en ce qui concerne la redirection et l'authentification. De 0 (pire) à 2 (meilleur) :

- 0 : aucune prise en charge d'IPv6 ;

- 1 : prise en charge expérimentale ou partielle (exemple : pas de redirection vers le portail captif en IPv6 donc obligation de s'authentifier en IPv4) ;

- 2 : prise en charge complète d'IPv6, y compris pour effectuer la redirection vers le portail captif.

- Il doit être compatible avec notre machine : nous n'avons pas de machine à consacrer à l'installation d'une solution ni l'envie de nous coltiner les problèmes d'interaction avec les fonctions avancées des réseaux que l'on retrouve avec les machines virtuelles. En conséquence, la solution retenue doit être bootable sur une clé USB ou être compatible Debian. « Oui » : la solution répond à cette exigence, « Non » sinon ;

- Il doit être maintenu et documenté. De 0 (pire) à 2 (meilleur) :

- 0 : la solution est un projet abandonné et peu documenté ;

- 1 : la solution est suffisamment documentée et le projet est maintenu de manière approximative ;

- 2 : le projet est encore maintenu et toute la documentation nécessaire est à disposition ;

- Il doit être facile à administrer après la configuration initiale. « Oui » : la solution dispose d'une interface web de configuration qui donne accès à tous les paramètres nécessaires pour mener à bien ce projet ainsi qu'à des stats pertinentes, « Non » sinon.

Lors d'une première passe, nous avons éliminé les solutions suivantes car elles ne sont pas gratuites ou pas libres : Air Marshal, Net4Guest, Aradial, Cloudessa, Cloud4Wi, DNS Redirector, FirstSpot, LogiSense, Amazingports, Ecnex, Untangle.

Nous avons appliqué nos critères précédemment énoncés sur les solutions restantes. En voici une synthèse :

| Nom | IPv6 | Compatibilité | Documentation | Facilité d'administration |

|---|---|---|---|---|

| ALCASAR | Non | ** | Oui | |

| Chillispot | Oui | Non | ||

| Coovachili | * | | ** |

Non |

|

| M0n0wall | Non | * | Oui | |

| PacketFence | Oui | ** | Oui | |

| PepperSpot | ** | Oui | ** | Non |

| PfSense | * | Non | ** | Oui |

| Talweg | Oui | Non | ||

| Wi-Fidog, NoCat | Non | * | Non | |

| Zentyal | Non | * | Oui | |

| Zeroshell | Non | ** | Oui |

On constate que seulement trois portails captifs se démarquent par une prise en charge (parfois minimale) d'IPv6 : Coovachilli, PfSense et PepperSpot. Coovachilli et PfSense disposent toutefois d'une prise en charge expérimentale incomplète : il n'y a pas de redirection pour authentification en IPv6.

La seule limite que nous avons trouvée à PepperSpot est l'utilisation d'une fenêtre pop-up qui doit rester ouverte pour que la machine reste authentifiée sur le réseau. Cela n'est pas pratique avec un ordiphone.

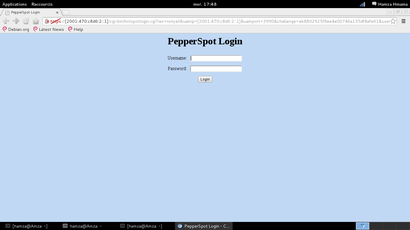

En conclusion, nous avons choisi le portail captif PepperSpot.

Si c'était aujourd'hui (en octobre 2016), je conseillerais de regarder attentivement du côté de PfSense qui est une solution tout intégrée qui a l'air d'avoir bien évolué depuis ce travail. Il n'était pas stable à l'époque (genre tes paramètres pouvaient disparaître alors que c'était tout bien configuré lors de la dernière utilisation), il l'est devenu, semble-t-il. En revanche, je ne sais pas s'il gère la redirection pour authentification en IPv6 ou s'il ne gère toujours pas cela.

Toujours en 2016, avec du recul, je fais remarquer qu'une solution toute intégrée est moins susceptible de vous faire progresser qu'une solution où il faudra installer, configurer et comprendre chaque composant qui constitue l'architecture finale. Dans un TP universitaire, j'ai tendance à penser qu'on doit tout décortiquer et comprendre, quitte à présenter une solution moins jolie visuellement ou moins ergonomique.

Utiliser le portail captif en tant que proxy RADIUS ?

Une connexion sécurisée (802.1X) à notre hotspot se fera via un autre SSID et l'authentification ne passera pas par PepperSpot qui peut être un proxy RADIUS.

Nous n'utiliserons pas cette fonctionnalité : notre point d'accès Cisco contactera directement notre serveur RADIUS pour authentifier les clients, principalement car l'utilisation d'un proxy RADIUS ajoute de la complexité inutile donc un risque de panne supplémentaire qui peut s'avérer difficile à débugger). Sans compter que bien séparer les deux réseaux, y compris pour l'authentification, nous permet de mieux répartir le travail entre nous : on installe le RADIUS et chacun de nous peut travailler sur l'un des SSID.

SSIDs

Ce n'est pas le plus important donc nous avons fait dans la simplicité (l'idée étant aussi d'éviter les doublons lors de la séance de TP dédiée à l'évaluation) :

- SSID pour le réseau avec le portail captif : TESTAP ;

- SSID pour le réseau avec l'authentification 802.1X : TESTAP-sec.

Adressage IP

IPv6

Allocation

En IPv6, la notion de rareté n'existe pas : la salle de travaux pratiques, comme d'autres, est irriguée par un /64 qui ne sera jamais saturé. Dans ce contexte, il convient de mener une réflexion sur l'adressage à déployer.

Dans un vrai déploiement, nous aurions la main sur les routeurs ascendants et nous pourrions donc router deux /64 distincts en direction de notre machine qui héberge notre portail captif.

Dans notre cas, deux pistes apparaissent : utiliser l'allocation d'OSIRIS ou utiliser une autre allocation.

La première méthode, utiliser l'allocation d'OSIRIS, implique de laisser passer toute la signalisation ICMPv6 (router solicitation, router advertisement, neighbor solicitation, neighbor advertisement, principalement). Cela peut être fait de deux manières :

- Au niveau 2, en utilisant un bridge. L'inconvénient majeur est que cela nuit à la compartimentation que nous souhaitons entre nos différents types d'accès (portail captif, accès sécurisé 802.1X) : le trafic multicast (IPv6, IPv4) et broadcast (IPv4), y compris celui généré par nos camarades, sera propagé sur nos deux réseaux Wi-Fi. Sans compter que cela complexifie probablement la configuration initiale de PepperSpot (il faut garantir qu'aucun paquet ne traverse le bridge avant que l'utilisateur ait été authentifié. Or, c'est le rôle même d'un bridge que de tout laisser passer).

- En laissant la machine hébergeant notre portail captif en coupure du réseau. Mais, comme nous n'avons pas la main sur le routeur qui annonce l'allocation, il faut un réseau à plat. Cela implique l'utilisation de la fonctionnalité de proxy NDP. D'abord manuelle, cette fonctionnalité peut être automatisée avec des logiciels spécialisés tels que ndppd. L'inconvénient majeur de cette approche est qu'elle complexifie notre installation au détriment de la facilité d'administration sans pour autant offrir des garanties en terme d'efficacité.

Dans les deux cas, nous utilisons la même allocation (le même /64) pour nos deux types d'accès (portail captif et accès sécurisé), ce qui n'est pas optimal d'un point de vue de la compartimentation.

La deuxième méthode (utiliser une autre allocation que celle d'OSIRIS, pour rappel) peut être décomposée ainsi :

- Utiliser une allocation locale unique (fc00::/7) ou réservée pour du benchmark et mettre en place du NAPT. Cette technique a fait son apparition dans la version 3.7 de Linux (donc elle est disponible dans Debian stable). En plus d'être controversée (au motif que ce n'est pas top de reproduire les erreurs commises avec IPv4), elle ne permettra pas l'usage de la mobilité IPv6, autre point de ce TP, sauf à utiliser des méthodes de contournement basées sur UDP (exemple) qui ne sont pas forcément prises en charge par toutes les implémentations… ;

- Utiliser 6in4, soit une encapsulation d'IPv6 sur IPv4. Ça fonctionne tout aussi bien en utilisant un VPN (OpenVPN, IPSec, etc.) qui fournit une connectivité IPv6, testé et approuvé en 2016. Attention si vous utilisez un tunnel de type tun : le nom peut entrer en conflit avec PepperSpot. Avec OpenVPN, il est possible de changer le nom de la tun avec la directive de configuration suivante : « dev tun

».

Nous avons retenu cette dernière méthode car elle nous semble plus propre, plus étanche et moins complexe : un tunnel prit chez Hurricane Electric route un /48 sur notre passerelle. De là, un /64 est alloué à chaque réseau (portail captif et accès sécurisé 802.1X) : 2001:470:c8d6:2::/64 pour TESTAP, 2001:470:c8d6:3::/64 pour TESTAP-sec.

Autoconfiguration stateless ou autoconfiguration stateful ?

En IPv6, l'annonce du routeur de sortie du réseau se fait exclusivement via les messages de contrôle (ICMPv6) « Router Advertisement » (RA). L'attribution des adresses (et d'autres paramètres comme les serveurs DNS récursifs à utiliser) peut se faire de deux manières : stateless (SLAAC) ou stateful (DHCPv6).

La difficulté vient de la différence de prise en charge par les différents systèmes d'exploitation, même les plus récents. En effet, si tous gèrent l'annonce du routeur de sortie via les messages RA (puisque c'est obligatoire dans la norme), tous ne prennent pas en charge, en standard, l'annonce des serveurs DNS récursifs par ce biais (option RDNSS). Avec de tels systèmes, on n'obtient pas une configuration dual stack : si IPv4 ne fonctionne plus, alors le serveur DNS récursif est injoignable et IPv6 reste dépendant d'IPv4, ce qui n'est pas l'objectif de ce TP, à notre avis.

DHCPv6 et les messages RA peuvent cohabiter selon deux modes :

- Mode « managed » : le message RA sert à indiquer exclusivement l'adresse du routeur de sortie. L'attribution des adresses est déléguée à un serveur DHCPv6 ;

- Mode « other configuration » : le message RA sert à indiquer l'adresse du routeur de sortie ainsi que le préfixe du réseau afin que les machines puissent s'autoconfigurer sans utiliser de serveur DHCPv6. Néanmoins, les machines qui supportent DHCPv6 peuvent effectuer une telle requête afin d'obtenir des informations d'autoconfiguration complémentaires (comme les adresses des serveurs DNS récursifs à utiliser).

Notons que ces modes de fonctionnement diffèrent simplement par des drapeaux à positionner dans les messages RA.

Sur notre réseau TESTAP-sec, nous utilisons le mode « other configuration » ainsi qu'un serveur DHCPv6, ce qui permet de prendre en compte un maximum de cas :

- Si le système d'exploitation prend en charge RDNSS et DHCPv6, alors il peut interroger le serveur DHCPv6 pour consolider les informations complémentaires (les adresses des serveurs DNS récursifs, par exemple) obtenues dans le message RA (RFC 4862, section 5.6) ;

- Si le système d'exploitation ne prend pas en charge RDNSS mais prend en charge DHCPv6 (exemples : Windows XP-8, Windows Phone 6.5-8, Solaris, etc.), il interrogera le serveur DHCPv6 pour connaître les adresses des serveurs DNS récursifs (et les autres informations complémentaires) à utiliser ;

- Si le système d'exploitation ne prend pas en charge DHCPv6 mais prend en charge RDNSS (exemples : MeeGo, (Free|Open)BSD, quelques systèmes GNU/Linux selon la configuration par défaut, etc.), il récupérera les adresses des serveurs DNS récursifs à utiliser directement dans les messages RA ;

- Si le système d'exploitation ne prend en charge ni RDNSS ni DHCPv6 (exemples : Android, Symbian), alors la résolution des noms de domaine est dépendante d'IPv4. À l'impossible, nul n'est tenu.

En 2016, je pense qu'il faudrait actualiser cette liste : je serai surpris qu'Android n'implémente pas au moins RDNSS.

Sur notre réseau TESTAP, nous utilisons uniquement les messages RA : DHCPdv6 ne peut pas se binder sur l'interface réseau testap car elle n'a pas d'IP (PepperSport l'attribue à une tun qu'il crée en démarrant) et il ne peut pas non plus se bind sur une interface point-à-point (la tun créée par PepperSpot), puisque DHCP est un protocole broadcast/multicast par essence.

IPv4

En IPv4, la question de l'allocation à utiliser ne se pose pas : en raison d'un manque d'adresses, il n'est pas possible d'attribuer une IPv4 provenant d'OSIRIS (réseau de l'université) à chacun de nos clients Wi-Fi. On a donc recours à des adresses privées et à du NAPT.

Dans notre cas, nous avons décidé d'utiliser deux /24 découpés dans le bloc 198.18.0.0/15 réservé à l'IANA pour les tests/benchmarks : 198.18.0.0/24 servira à adresser notre réseau TESTAP et 198.18.1.0/24 servira à adresser notre réseau TESTAP-sec.

Notons que nous utilisons 198.18.255.0/31 pour adresser le lien d'administration de notre point d'accès Wi-Fi.

Les blocs réservés pour un usage privé seraient plus appropriés mais nous voulions impérativement éviter les collisions avec des adressages existants (typiquement à nos domiciles respectifs).

Gestion du RADIUS

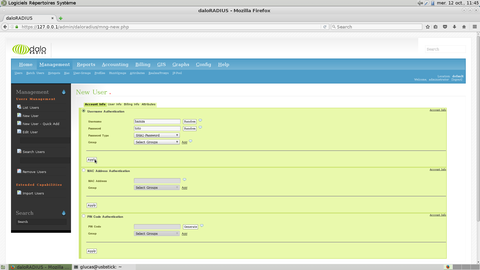

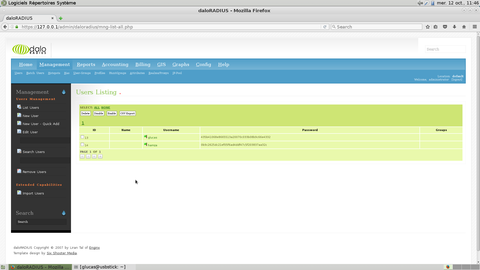

Deux consignes informelles ont été ajoutées en cours de route. La première est que le RADIUS doit récupérer et stocker les informations sur nos utilisateurs dans une base de données genre MySQL. La deuxième, qui découle de la première, est que la gestion de cette base doit se faire avec une interface web : il n'est pas question d'ajouter ou de supprimer un utilisateur ni de consulter l'accounting avec des bouts de scripts ou manuellement.

Pour ce faire, nous avons choisi le logiciel daloRADIUS. Nous avions aussi identifié dialupadmin par les auteurs de FreeRADIUS mais son interface web est un peu rustique à notre goût.

De toute façon, aucun des logiciels libres de gestion des données d'un serveur RADIUS que nous avons identifiés ne permet nativement de travailler avec les IPv6 attribuées aux utilisateurs de nos réseaux Wi-Fi. Mais, ce n'est pas vraiment un problème puisque, pour notre réseau TESTAP-sec, nous verrons que notre AP Cisco ne communique pas les IP d'un utilisateur dans ses requêtes d'accounting. Pour notre réseau TESTAP, PepperSpot autorise l'utilisateur à utiliser uniquement une IPv6 strictement dérivée de son adresse MAC. Dans ce contexte, l'accounting IPv6 est inutile : la MAC est dans l'adresse IPv6 (avec un ff:fe en plus en plein milieu, certes). Donc, il suffit d'extraire la MAC à partir de l'IPv6 et de rechercher l'identifiant à partir de cette adresse-là (qui est stockée dans l'accounting RADIUS).

Après coup, nous nous sommes rendu compte que le code de dalORADIUS laisse à désirer : des fonctionnalités présentes sur l'interface web n'ont aucun code derrière (exemple : le stockage d'un mot de passe utilisateur haché avec SHA1), le code est doublonné (code identique dans plusieurs pages) ce qui rend difficile l'ajout d'une fonctionnalité à l'existant, les requêtes de comptage du nombre de lignes présentes dans la BDD sont insensées, la cohérence du code (pour une même action, les traitements diffèrent parfois d'une page à une autre) laisse à désirer, aucune convention de codage, etc.

Mécanismes d'authentification 802.1X

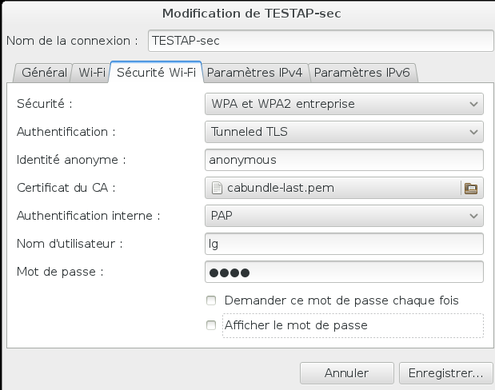

Pour l'authentification, 802.1X utilise EAP qui est un protocole générique de transport de méthodes d'authentification (voir http://www.bortzmeyer.org/3748.html). Parmi toutes les méthodes d'authentification disponibles, nous avons choisi d'utiliser EAP-TTLS-(PAP|CHAP) sur notre SSID sécurisé.

TTLS (Tunneled TLS) se justifie car :

- TTLS est un mécanisme fiable et normalisé à l'IETF ;

- LEAP est un mécanisme propriétaire de Cisco qui est vulnérable depuis plus de 10 ans ;

- PEAP est similaire à TTLS mais les mécanismes d'authentification utilisables dans le tunnel sont faibles : MSCHAPv2 et MD5. MD5 n'est plus considéré comme sûr depuis plus de 10 ans. Nous allons évoquer MSCHAPv2 ci-dessous ;

- TLS est trop contraignant car il faut réaliser une authentification du client avec un certificat x509 en plus du certificat x509 du serveur, ce qui nuit à un usage à grande échelle ;

- Les autres méthodes sont peu implémentées/utilisées.

Pour réaliser l'authentification à l'intérieur du tunnel TLS au-dessus d'EAP, plusieurs mécanismes sont possibles :

- MSCHAP(v2), une implémentation de CHAP réalisée par Microsoft qui est totalement trouée de nos jours puisqu'il repose sur l'algorithme cryptographique DES et ses clés de 56 bits ;

- MD5, qui n'est plus considéré comme sûr pour des opérations cryptographiques. Certes, on est à l'intérieur d'un tunnel TLS mais son nom est trop connu : son utilisation ici pourrait faire croire à nos utilisateurs qu'il est un algorithme potable et conduire à des erreurs d'appréciation dans leurs projets (pouvoir de prescription) ;

- CHAP, qui a recours à une fonction de hachage, ce qui rajoute une surcouche inutile à un tunnel TLS bien négocié, à notre avis, mais rien n'empêche de l'utiliser ;

- PAP, qui est un mécanisme simple qui envoie l'identifiant et le mot de passe en clair dans le tunnel TLS. Pas de protection contre les rejeux comme en propose CHAP mais TLS s'occupe aussi de cela.

C'est pourquoi nous avons choisi de tolérer PAP et CHAP comme mécanismes d'authentification au sein de nos tunnels EAP-TTLS, sur notre réseau TESTAP-sec.

Supervision et métrologie

Note de 2016 : dans un vrai déploiement, il faudrait plutôt ajouter notre service Wi-Fi à la supervision existante et ne pas déployer des outils de supervision/métrologie sur la passerelle du réseau Wi-Fi comme nous allons le faire. Néanmoins, c'était l'une des consignes du TP et je pense qu'elle a pour but de nous faire mettre en œuvre une solution de supervision… même si une autre matière du programme, administration des réseaux (si ma mémoire est bonne), poursuit le même objectif.

Supervision

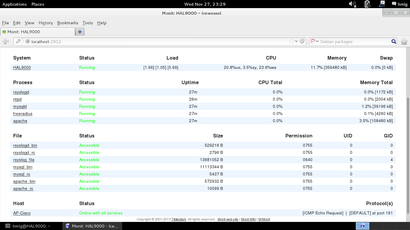

Nous utilisons Monit pour superviser les services cruciaux de notre infrastructure :

- Point d'accès Cisco : ping et SNMP ;

- Apache : processus lancé et tentative de requête ;

- Freeradius : processus lancé et tentative de requête ;

- MySQL : processus lancé et tentative de requête ;

- Rsyslogd : processus lancé ;

- NTPd : processus lancé et tentative de requête ;

- DHCP(v6) : processus lancé (Monit ne supporte pas ce protocole pour une tentative de requête).

Nous avons choisi Monit pour sa simplicité d'où il ne va pas bombarder notre clé USB bootable d'IO. Il suffit amplement pour atteindre l'objectif fixé par ce TP. Et j'écris ça avec du recul, après avoir touché à du Zabbix, à du Centreon et à du Icinga (1.X et 2.X) (tous des usines à gaz) dans mes expériences pros et associatives depuis ce TP. Un avantage de Monit, c'est qu'il vérifie facilement, sans trop de configuration, que des processus sont en cours d'exécution. Utile pour superviser rsyslog sans faire entrer des données prédictibles dans les logs, par exemple.

Monit est un logiciel de monitoring extrêmement limité, aussi bien en terme de protocoles supportés qu'en terme de tests effectués : le fait qu'un processus soit lancé ne signifie pas forcément qu'il va servir la requête d'un utilisateur ; envoyer un paquet générique pour vérifier qu'un port est ouvert est insuffisant. Illustration (hors cadre de ce TP) : tester qu'un serveur DNS qui fait autorité répond est insuffisant : il faut comparer les serials de tous les SOA de tous les serveurs qui font autorité sur une même zone, entre autres choses. Néanmoins, Monit est suffisant et cohérent dans le cadre de ce projet. Notons néanmoins que la version de Monit packagée dans Debian Jessie n'est pas compatible IPv6…

La principale limite de notre infrastructure de supervision est qu'elle teste les services indépendamment les uns des autres. Mais ce n'est pas parce qu'on vérifie qu'Apache sert bien la page de notre portail captif que ça signifie qu'il n'y aura aucun problème lors de la soumission d'un couple identifiant/mot de passe. Pour être sûr que toute notre infrastructure fonctionne, il faudrait tester la chaîne de bout en bout : connexion sur chaque SSID, authentification, envoi de trafic vers une mire choisie en v4 et en v6, etc. À notre connaissance, aucun logiciel n'existe pour faire un tel test de bout en bout.

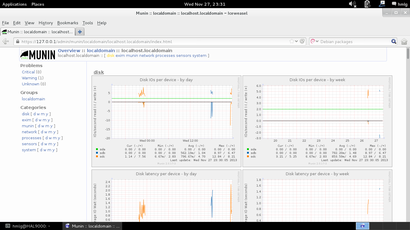

Métrologie

Nous utilisons Munin pour grapher les composants de la machine qui héberge notre portail captif : charge CPU, utilisation mémoire, nombre de processus, entrées/sorties sur les périphériques de stockage, température, etc. Autant de facteurs qui peuvent révéler des anomalies en cours ou passées (puisque nous avons un historique). De même, nous graphons le trafic sur les différentes interfaces réseau, ce qui nous permet de constater, par des données chiffrées, l'utilisation de nos deux réseaux Wi-Fi.

Nous avons choisi munin pour sa renommée et sa simplicité de configuration et d'utilisation dans un contexte aussi simple que le nôtre.

Typologie des flux réseaux

Pour moi, en 2016, je pense que nous sommes au-delà de ce que devrait s'autoriser à faire un FAI mais ce n'est pas illégal pour autant. Ce point est exigé dans le sujet et il nous a été rappelé lors de la première séance de notation.

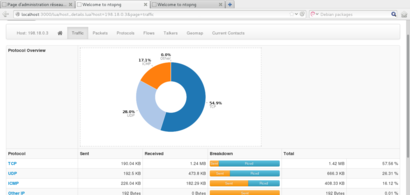

Pour obtenir une visualisation fine des flux réseaux qui passent via notre hotspot, nous utilisons ntop-ng, version améliorée de ntop : interface web revue (moins de bugs, plus efficace), plus de données volumétriques récoltées et affichées, etc. Ça vaut bien un Netflow / IPFix.

Après coup, je trouve curieux que le prof' nous ait indiqué ce logiciel (ou plus précisément sa première version, ntop) alors qu'il se met en écoute uniquement en IPv4. 😉

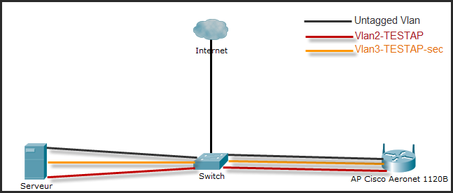

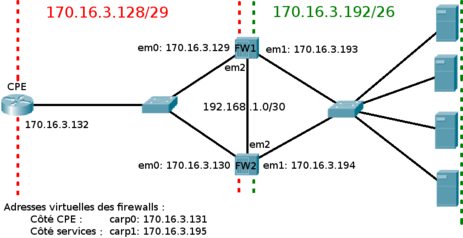

Architecture déployée

Voici un schéma général de l'architecture du réseau que nous avons déployé :

Nous utilisons un switch car notre machine passerelle est équipée d'une seule carte réseau filaire. Notre machine (appelée serveur sur le schéma) regroupe l'intégralité des services utilisés : PepperSpot, RADIUS, MySQL, Apache, DHCP(v4/v6), radvd, etc.

VLANs

Dans notre architecture, nous avons deux SSID : TESTAP, qui redirige le client vers notre portail captif PepperSpot et TESTAP-sec qui utilise une authentification 802.1X. Chaque SSID est affecté à un VLAN : numéro 2 pour TESTAP, numéro 3 pour TESTAP-sec. Les communications inter-VLAN, ou depuis un des réseaux Wi-Fi vers le réseau de management du point d'accès Wi-Fi, sont interdites.

Le VLAN numéro 1 chez Cisco est le VLAN de management natif (pas tagué) et nous l'utilisons pour toutes les communications avec le point d'accès : RADIUS pour 802.1X, configuration en ligne de commande (SSH) du point d'accès, etc.

Sur les modèles Aironet de Cisco, il est possible de changer l'ID du VLAN natif de management, mais il est impossible de taguer ce VLAN. En conséquence, nous utilisons l'aliasing IP pour configurer notre machine passerelle sur nos différents réseaux et pour différencier le trafic entrant/sortant depuis/vers Internet et le trafic circulant sur le VLAN de management.

Données de connexion

Généralités

La législation française impose aux Fournisseurs d'Accès à Internet (FAI) de communiquer aux autorités, dans le cadre d'une procédure judiciaire, toutes les informations associées à une adresse IP dont le FAI aurait connaissance. Cette obligation court pendant un an.

Dans un contexte de 56k avec une identification "toto/toto", le FAI donne le numéro de téléphone appelant. Dans un contexte de VPN "open-bar", le FAI communique l'IP source qui a servie à monter le tunnel. Dans un contexte de Wi-Fi ouvert, le FAI donne l'adresse MAC (c'est par exemple le cas à l'aéroport de Toulouse-Blagnac). Il n'y a pas d'obligation de conserver une identité au sens identité d'état civil.

Si c'est un-e abonné-e et que le FAI a des infos sur lui-elle (identité, adresse postale, adresse mail, autre), il doit les donner.

S'il s'agit d'un service payant, le FAI doit garder les informations relatives au paiement.

S'il y a la création d'un compte, il faut communiquer les hashs et la réponse aux questions secrètes mais pas le mot de passe en clair.

Il est strictement interdit (CPCE) de garder trace de qui a visité tel site. Il est interdit de conserver tout ce qui touche au contenu ou à la navigation.

Les consignes informelles données lors de ce TP font que l'on sent qu'une association IP(v4|v6)<->identifiant est attendue. C'est donc dans cette direction que nous avons creusée même si cela n'est pas nécessaire d'un point de vue légal si l'on dispose de blocs IP dédiés aux réseaux Wi-Fi, comme nous venons de le formuler ci-dessus.

Authentification UAM

PepperSpot garantit l'association identité<->MAC<->IP. L'utilisateur ne peut pas changer d'IPv4 ni d'IPv6 après son authentification. Par ailleurs, le seul schéma d'adressage IPv6 pris en charge par PepperSpot est celui dans lequel l'adresse IPv6 dérive de l'adresse MAC. Il n'est donc pas possible d'utiliser les adresses IPv6 temporaires des extensions pro-vie privée, par exemple (PepperSpot est donc incompatible avec un client Wi-Fi Unbuntu sans une désactivation préalable de ces extensions).

Ici, le portail captif est un NAS dans la terminologie RADIUS. L'accounting RADIUS de base enregistre les informations suivantes à propos du client : identifiant, MAC, IPv4, début de la session, fin de la session, octets envoyés et reçus.

Néanmoins, nous avons complété cet accounting de base :

- Nous avons positionné la valeur « 120 » pour l'attribut « Acct-Interim-Interval ». Cela permet de forcer le portail captif à faire une mise à jour de l'accounting toutes les deux minutes, histoire d'avoir des informations actualisées sur nos clients Wi-Fi.

- Nous avons positionné la valeur « 600 » pour l'attribut « Idle-Timeout ». Cela permet de déconnecter un utilisateur qui aurait oublié de se déconnecter manuellement au bout de 10 minutes d'inactivité (au niveau réseau).

- Nous aurions pu positionner l'attribut « Session-Timeout » pour donner un temps maximal à la connexion à notre hotspot Wi-Fi et pour forcer l'utilisateur à se re-identifier comme cela se fait dans les trains et les aéroports, mais c'est extrêmement contraignant donc nous ne l'avons pas fait.

- Nous avons modifié le schéma de la base de données et les requêtes d'accounting que freeRADIUS effectue afin d'intégrer le stockage de l'IPv6 de notre client Wi-Fi. Nous avons également modifié daloRADIUS (interface web pour configurer simplement le RADIUS, pour rappel) afin qu'il récupère et affiche ces IPv6.

Pour notre réseau TESTAP, conserver l'accounting RADIUS est suffisant pour atteindre l'objectif fixé.

Authentification 802.1X

L'authentification 802.1X garantit uniquement l'association entre une adresse MAC et un couple identifiant/mot de passe. On est donc en couche 2 uniquement. Dans cette configuration, nous n'avons plus le contrôle forcené de notre portail captif : l'utilisateur peut changer d'IP, v4 comme v6, après son authentification.

De plus, dans cette configuration, le NAS est notre point d'accès Cisco. Or, ce dernier n'envoie pas les IP obtenues par le client Wi-Fi dans les requêtes d'accounting (accounting-request) bien que le point d'accès connaisse l'IPv4 du client et l'affiche dans la sortie de la commande « sh dot11 associations » même si ce dernier en change après authentification. En revanche, l'adresse IP d'un client peut-être récupérée via SNMP mais, à l'inverse, l'adresse MAC de ce même client ne peut pas être récupérée car cela n'est pas prévu dans la MIB. Cela nous est donc inutile : nous avons besoin de stocker ces deux informations pour avoir une association entre identifiant et IP.

Nous pouvons conserver les logs DHCP (v4 et v6) mais ils sont insuffisants : un utilisateur peut fixer ses adresses IP manuellement. De plus, en IPv6, l'autoconfiguration stateless permet de se passer de DHCPv6, ce qui rend inutile tout log DHCPv6.

Sur OSIRIS(-sec), la direction informatique (DI) de l'université collecte toutes les adresses MAC sur tous les commutateurs et toutes les associations MAC<->IP sur les routeurs. Un outil interne agrège toutes les données (association identité<->MAC<->IP) et un moteur de recherche, développé aussi en interne, permet de retrouver la bonne information en cas de réquisition. Il ne leur semble pas exister de solution plus fiable.

Dans le cadre de ce projet, nous avons mis en place une solution similaire à celle déployée sur OSIRIS(-sec) mais sans l'énergie dépensée par la DI : nous enregistrons les associations MAC<->IP avec deux logiciels : arpwatch (IPv4) et ndpmon (IPv6). Dès qu'un client Wi-Fi émet sur le réseau, pouf, nous avons l'association entre son adresse MAC et ses IPs. Toute machine qui rejoint le réseau ou change sa MAC ou reprend une IP allouée à quelqu'un d'autre sera détectée. En cas de réquisition judiciaire concernant une IP, il suffira de chercher, dans les logs arpwatch et ndpmon, la MAC associée puis d'aller chercher les informations (identité, plage horaire de connexion, etc.) relatives à cette adresse MAC dans l'accounting RADIUS. Le développement d'un moteur de recherche convivial dépasse le cadre de ce TP.

Outro

Nous avons aussi mis en place une conservation des associations MAC<->IP sur le SSID UAM dans un objectif de sécurité supplémentaire (ceinture et bretelles). Les logs ainsi produits peuvent être croisés avec l'accounting RADIUS afin d'être sûrs de la véracité de l'information, par exemple.

Note : pour enregistrer les associations IPv6<->MAC, nous aurions pu avoir recours à Netfilter pour noter tous les messages ICMPv6 « Neighbor Advertisement ». Il ne semble rien exister de tel pour IPv4 pour l'environnement GNU/Linux (iptables travaille à partir de la couche 3 donc au-dessus d'ARP et arptables n'implémente pas de cible « LOG »). De plus, arpwatch et ndpmon permettent de prévenir les administrateurs de toute tentative (même infructueuse) d'usurpation d'une adresse MAC, ce que ne permet pas un simple log ip6tables. Pour bénéficier de cette dernière fonctionnalité, il faudra simplement activer les fonctionnalités d'envoi de mail en cas d'événements critiques dans ces deux logiciels. Mais cela dépasse le cadre de ce TP.

Page d'administration

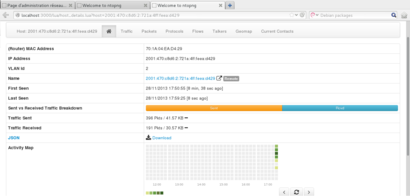

La tâche principale d'administration, à savoir ajouter/supprimer un utilisateur afin que celui-ci ait accès ou non à notre hotspot, se fait avec daloRADIUS, interface web qui permet d'interagir avec la base de données utilisée par freeRADIUS.

La supervision et la métrologie se vérifient à partir des interfaces web des outils déployés (monit, munin, ntop-ng).

Les autres tâches (mises à jour du système, maintenance, consultation des logs, etc. ) se réalisent en ligne de commande.

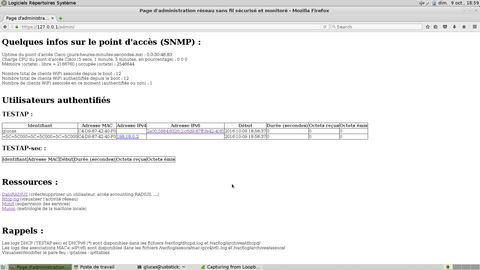

De manière informelle, il nous a été demandé de créer une sorte de page d'accueil de nos outils d'administration : une page qui afficherait les informations importantes issues de l'accounting RADIUS concernant les utilisateurs actuellement connectés à notre hotspot et qui proposerait des liens pertinents vers les outils d'administration que nous avons déployés (exemple : un lien sur une IP conduirait à la page ntop-ng concernant cette IP).

Partant de là, nous avons décidé de récupérer des données intéressantes (uptime, charge CPU, mémoire, nombre de clients Wi-Fi connectés, etc.) depuis notre point d'accès Cisco en utilisant SNMP et de les afficher sur cette page d'administration. Histoire de montrer qu'on sait vaguement utiliser SNMP, étudié précédemment dans une autre matière (administration des réseaux, si ma mémoire est bonne).

Cette page d'administration est disponible sur https://localhost/admin. (en IPv4 et en IPv6, forcément 😉 ). Identifiant/mdp : toor/toor.

Mobilité IPv6

Kézako ?

L'idée derrière la mobilité IP (ça existe aussi en IPv4), c'est qu'une machine conserve ses IP lorsqu'elle change de réseau, ce qui lui permet de conserver ses connexions actives. Utilité ? Les chercheurs voient ça pour les voitures connectées qui devront se connecter à des réseaux différents tout au long de leur déplacement. Ou pour nos ordiphones, qui pourraient ainsi passer d'un réseau Wi-Fi à un réseau 4G sans interruption de service.

Comment cela se matérialise-t-il ? Un entête IPv6 "mobility" chaîné à un entête IPv6 standard, des options IPv6, de nouveaux messages ICMPv6, etc. En gros, cela forme un tunnel similaire à un tunnel ip6ip6. Ce tunnel peut être protégé par IPSec. À mes yeux, c'est donc une énième solution de tunneling. Je pense que le principal avantage de MIPv6 est sa légèreté dans un usage avec chiffrement (comparé à un OpenVPN en couche 7 + userland ou à du IPSec + GRE, par exemple).

Choix de l'implémentation

Nous avons utilisé umip (ex-mipd6) simplement parce que le prof' a dit que c'était l'implémentation qu'il utilise pour monter le Home Agent avec lequel notre Mobile Node devra communiquer. Cette partie du sujet ne nous a pas semblé être assez significative pour justifier une recherche et une comparaison d'autres implémentations.

Quand la mobilité IP rencontre BCP38

Nous avons constaté qu'il est impossible d'installer un Mobile Node IPv6 derrière une connexion Free ou FDN (et sans doute d'autres fournisseurs d'accès à Internet). Hurricane Electric (fournisseur de tunnels 6in4) n'est pas concerné.

Après quelques recherches, nous avons constaté que le « Binding Update » parvient jusqu'au Home Agent (celui installé par le prof' ou un autre, sur un réseau sur lequel nous avons la main) mais que le « Binding Ack » n'atteint pas le Mobile Node.

Cela ne peut pas venir d'un blocage (à cause des options IPv6 utilisées, par exemple) puisque l'un des fournisseurs d'accès à Internet que nous utilisons, FDN, fait de la neutralité du réseau son cheval de bataille.

La cause la plus probable semble être l'utilisation, par ces FAI, de l'ingress filtering (RFC 2827 et 3704 pour les réseaux multihomés, dit BCP38). En effet, l'ingress filtering posait problème avec la mobilité IPv4 (voir la section 5 du RFC 2827) et peut encore en poser avec Mobile IPv6 même si le Mobile Node ne met plus sa home address comme source des paquets qu'il émet (voir, entre autres, ce brouillon de standard).

En 2016, je suis en mesure de confirmer cette hypothèse. En installant un Home Agent dans une VM ARN et un Mobile Node chez Grifon, je constate que le message « Binding Ack » est filtré par le routeur d'entrée de Grifon lorsque le mécanisme bcp38 est activé.

Mise en œuvre

Configurer un point d'accès Cisco Aironet 1120B

La première étape, c'est de revenir à la configuration par défaut. On zieute les instructions de Cisco. En résumé : il faut appuyer sur le bouton « MODE » tout en allumant l'AP, jusqu'à ce que la LED change de couleur.

Après son redémarrage automatique, la borne récupérera une IPv4 via DHCP et on pourra se connecter à l'interface d'admin en telnet en utilisant le couple identifiant/mdp Cisco/Cisco.

On configure les paramètres principaux : nom, domaine, ajout d'un utilisateur, suppression de l'utilisateur Cisco, activer SSH, assigner une IP à l'interface d'administration, etc. Pour cela, on suit ce tutoriel : Configuration minimale d'une borne Cisco Aironet 1200 Series.

Ensuite, on vire CDP :

interface fa0 no cdp enable interface Dot11Radio0 no cdp enable |

Maintenant, créons nos VLAN. D'abord, le VLAN d'administration (natif, pas tagué) :

interface fa0.1 description admin encapsulation dot1Q 1 native bridge-group 1 no cdp enable bridge-group 1 spanning-disabled |

Puis on crée les VLANs de nos réseaux Wi-Fi :

interface fa0.2 description TESTAP encapsulation dot1Q 2 bridge-group 2 no cdp enable bridge-group 2 spanning-disabled interface fa0.3 description TESTAP-sec encapsulation dot1Q 3 bridge-group 3 no cdp enable bridge-group 3 spanning-disabled |

On crée les interfaces Wi-Fi qui correspondent :

interface Dot11Radio0.2 description TESTAP encapsulation dot1Q 2 bridge-group 2 no cdp enable bridge-group 2 spanning-disabled interface Dot11Radio0.3 description TESTAP-sec encapsulation dot1Q 3 bridge-group 3 no cdp enable bridge-group 3 spanning-disabled |

On crée nos deux SSID :

dot11 ssid TESTAP vlan 2 authentication open mbssid guest-mode dot11 ssid TESTAP-sec vlan 3 authentication open mbssid guest-mode |

On accroche nos SSID aux interfaces radio et on allume l'interface :

interface Dot11Radio 0 mbssid ssid TESTAP ssid TESTAP-sec no sh |

Notre point d'accès est désormais configuré, à l'exception de l'authentification 802.1X, de SNMP et d'autres bricoles que nous ajouterons en cours de route. Faisons les choses dans l'ordre pour un debug plus facile.

Pour rappel : sur les modèles Aironet de Cisco, il est possible de changer l'ID du VLAN natif de management, mais il est impossible de taguer ce VLAN.

Configurer un point d'accès Linksys WRT54GL avec OpenWRT

Nous n'avions pas d'équipements compatibles avec OpenWRT lors de la réalisation de ce TP, mais, lors de la publication de ce travail en 2016, j'ai trouvé intéressant de le reproduire avec un AP fonctionnant avec OpenWRT.

Pour revenir à une config par défaut, je re-flashe le WRT54GL. On est limité à la version Backfire 10.03.01, déclinaison brcm2.4 d'OpenWRT. Les versions plus récentes d'OpenWRT ou celles de la déclinaison brcm47 sont inutilisables sur un WRT54GL (lenteurs, plantages, etc.).

Là aussi, on fait la config' de base via telnet (192.168.1.1, pas d'identifiant/mdp). On change le mot de passe de root (ce qui active SSH) avec la commande « passwd » habituelle. On change le nom de la machine (et le fuseau horaire) dans le fichier « /etc/config/system ».

On veut un AP passif donc on désactive le pare-feu, le serveur DHCP, l'interface web et d'autres bricoles.

J'ai décidé d'utiliser le port WAN pour faire passer mes VLANs car il s'agit déjà d'un port physiquement isolé des autres, ce qui ressemble fortement à l'AP Cisco qui a un unique port.

Créons nos VLANs dans /etc/config/network. D'abord, je supprime toute la config sauf :

#### VLAN configuration

config switch eth0

option enable 1

config switch_vlan eth0_1

option device "eth0"

option vlan 1

option ports "4 5"

#### Loopback configuration

config interface loopback

option ifname "lo"

option proto static

option ipaddr 127.0.0.1

option netmask 255.0.0.0

|

Ensuite, ajoutons l'interface d'administration (VLAN 1 pas tagué) à la fin du fichier :

### Admin iface configuration

config interface admin

option ifname "eth0.1"

option proto static

option ipaddr 198.18.255.1

option netmask 255.255.255.254

|

Dans la section sur la configuration des VLANs, on ajoute les VLANs de nos réseaux Wi-Fi :

config switch_vlan eth0_2

option device "eth0"

option vlan 2

option ports "4t 5t"

config switch_vlan eth0_3

option device "eth0"

option vlan 3

option ports "4t 5t"

|

Correspondance entre les ports physiques et les ports logiques : port physique Internet = 4, port physique 1 = 3, port physique 2 = 2, port physique 3 = 1, port physique 4 = 0, CPU (pour dire que le WRT54GL fait partie du VLAN et s'il doit le taguer ou non) = 5.

Notons que, contrairement à notre Aironet Cisco, il est parfaitement possible d'isoler la liaison de management avec l'AP dans un VLAN tagué en ajoutant des « t » dans « ports » de « eth0_1 ». Il faudra créer le VLAN (avec l'ID 1, du coup, mais ça se change) sur la passerelle. Si nous faisions cela, ça change un peu les règles de filtrage que nous écrirons plus loin.

On crée les interfaces bridges associées aux VLANs :

# VLAN ifaces configuration

config interface testap

option type bridge

option ifname "eth0.2"

option proto static

option ipaddr 192.0.2.1

option netmask 255.255.255.255

config interface tapsec

option type bridge

option ifname "eth0.3"

option proto static

option ipaddr 192.0.2.2

option netmask 255.255.255.255

|

Attention : il ne faut pas que les deux noms d'interface se ressemblent trop (du genre « testap - testapsec », début identique) sinon un seul bridge sera créé.

Oui, il faut assigner des IP bidons (ici, il s'agit d'IP qui font partie du bloc réservé à l'IANA pour écrire de la documentation). Sinon, il faut ajouter une ligne « option proto none » pour chaque bridge. Mais cela entraîne l'erreur : « /sbin/Wi-Fi: eval: line 1: syntax error: bad substitution » et cela empêche les interfaces VLAN filaires d'être configurées et montées automatiquement au boot. Si l'on tente de ne pas mettre « option proto none », on obtient l'erreur « Interface not found » et le même comportement de non-configuration au boot.

On crée nos SSID, on les associe à l'interface radio et à nos VLANs et on active l'interface radio. Le tout dans /etc/config/wireless :

config Wi-Fi-iface

option device wl0

option network testap

option mode ap

option ssid "TESTAP"

option encryption none

config Wi-Fi-iface

option device wl0

option network tapsec

option mode ap

option ssid "TESTAP-sec"

option encryption none

|

Évidemment, je supprime le SSID « OpenWrt » créé par défaut.

Pour appliquer les modifications :

/etc/init.d/network restart |

Notons que la session telnet va être interrompue à cause du retrait du bout de config "LAN". Il faudra se brancher sur le port WAN et établir une nouvelle session telnet.

La rupture de la session telnet peut interrompre prématurément le restart. Il peut donc être nécessaire de l'exécuter une deuxième fois pour que l'ensemble de la config' devienne effectif.

Vous pouvez obtenir l'erreur « Command 'set ssid' failed: -1 » qui semble être une race condition (le SSID est assigné deux fois dont une fois quand l'interface est allumée d'où le driver sort en erreur) corrigée dans les nouvelles versions d'OpenWRT.

Installer un système Debian GNU/Linux sur une clé USB bootable

Ce tutoriel reste toujours d'actualité : Installing Debian on a USB stick (from a running Debian system). Si vous installez un environnement graphique, pensez également à installer un gestionnaire d'affichage genre gdm3.

Configuration de base de la passerelle

Virer avahi

On n'a pas besoin de cette pourriture sur nos réseaux donc :

sudo systemctl disable avahi-daemon.service avahi-daemon.socket sudo systemctl mask avahi-daemon.service avahi-daemon.socket |

NTP

Il est important de maintenir notre système à l'heure, notamment car c'est l'heure locale qui servira à horodater les logs et l'accounting RADIUS.

On installe l'implémentation NTP de référence :

sudo apt-get install ntp |

Config' à mettre dans /etc/ntp.conf :

disable monitor restrict default ignore restrict ntp-p1.obspm.fr nomodify notrap nopeer noquery restrict canon.inria.fr nomodify notrap nopeer noquery restrict 127.0.0.1 restrict ::1 server ntp-p1.obspm.fr iburst prefer server canon.inria.fr iburst # Undisciplined Local Clock. This is a fake driver intended for backup # and when no outside source of synchronized time is available. server 127.127.1.0 fudge 127.127.1.0 stratum 10 restrict 127.127.1.0 # Driftfile. driftfile /var/lib/ntp/ntp.drift |

On redémarre NTPd avec cette nouvelle config' :

sudo systemctl restart ntp

|

IPv6

Soit monter un tunnel 6in4 fournit par Hurricane Electric ou SixXS par exemple, soit monter un tunnel quelconque (OpenVPN, IPSec) qui fournit une connectivité IPv6 avec au moins 2 * /64. Je vous laisse faire. 🙂

/etc/network/interfaces

Voici notre fichier /etc/network/interfaces :

# Internet auto eth0 iface eth0 inet dhcp # IPv6 connectivity auto he-ipv6 iface he-ipv6 inet6 v4tunnel address 2001:470:1f12:273::2/64 endpoint 216.66.84.42 local 130.79.92.13 ttl 255 gateway 2001:470:1f12:273::1 # AP management auto eth0:0 iface eth0:0 inet static address 198.18.255.0/31 # TESTAP auto testap iface testap inet manual post-up ip link add link eth0 name $IFACE type vlan id 2 2> /dev/null || true post-up ip link set $IFACE up post-up ip addr add 198.18.0.1/24 dev $IFACE pre-down ip addr del 198.18.0.1/24 dev $IFACE iface testap inet6 static address 2001:470:c8d6:2::1/64 # TESTAP-sec auto tapsec iface tapsec inet manual post-up ip link add link eth0 name $IFACE type vlan id 3 2> /dev/null || true post-up ip link set $IFACE up post-up ip addr add 198.18.1.1/24 dev $IFACE pre-down ip addr del 198.18.1.1/24 dev $IFACE iface tapsec inet6 static address 2001:470:c8d6:3::1/64 |

On applique la nouvelle config' :

sudo systemctl restart networking

|

Activer l'IP forward

Dans /etc/sysctl.conf, décommenter :

net.ipv4.ip_forward=1 net.ipv6.conf.all.forwarding=1 |

On applique :

sudo sysctl -p |

radvd

On installe :

sudo apt-get install radvd |

On configure en mettant ce qui suit dans /etc/radvd.conf :

# TESTAP

interface testap

{

AdvSendAdvert on;

MaxRtrAdvInterval 10;

# "You can use DHCPv6 to obtain moar informations"

# AdvManagedFlag on;

AdvOtherConfigFlag on;

prefix 2001:470:c8d6:2::/64

{

};

RDNSS 2a00:5881:8100:1000::3

{

};

RDNSS 2a00:5884:8218::1

{

};

};

# TESTAP-sec

interface tapsec

{

AdvSendAdvert on;

MaxRtrAdvInterval 10;

# "You can use DHCPv6 to obtain moar informations"

# AdvManagedFlag on;

AdvOtherConfigFlag on;

prefix 2001:470:c8d6:3::/64

{

};

RDNSS 2a00:5881:8100:1000::3

{

};

RDNSS 2a00:5884:8218::1

{

};

};

|

On abuse un peu sur le MaxRtrAdvInterval (par défaut, il est configuré à 600 secondes, soit 10 minute) tout en restant au-dessous du minimum indiqué dans le manuel de radvd (4 secondes). L'idée première est de parer les pare-feu qui bloquent l'ICMPv6 en sortie donc les « Router Solicitation » sans pour autant bloquer les « Router Advertisement ». Cela permet aussi de garantir que nos clients Wi-Fi auront rapidement une IPv6 afin de montrer au prof' que PepperSpot redirige bien l'utilisateur pour authentification, même en IPv6. Sur un vrai déploiement en dual stack, il faudrait augmenter cette valeur.

On fait prend en compte la nouvelle configuration :

sudo systemctl restart radvd

|

DHCP

DHCPv4

On installe l'implémentation de référence :

sudo apt-get install isc-dhcp-server |

On écrit la configuration dans /etc/dhcp/dhcpd.conf :

# Seems great for a Wi-Fi network

default-lease-time 1800; # 30 mns

max-lease-time 25200; # 7 H

authoritative;

log-facility local7;

# TESTAP

subnet 198.18.0.0 netmask 255.255.255.0

{

range 198.18.0.10 198.18.0.254;

option subnet-mask 255.255.255.0;

option broadcast-address 198.18.0.255;

option routers 198.18.0.1;

option domain-name-servers 89.234.141.66, 89.234.186.18;

}

# TESTAP-sec

subnet 198.18.1.0 netmask 255.255.255.0

{

range 198.18.1.10 198.18.1.254;

option subnet-mask 255.255.255.0;

option broadcast-address 198.18.1.255;

option routers 198.18.1.1;

option domain-name-servers 89.234.141.66, 89.234.186.18;

}

|

On fait prendre en compte la nouvelle config' :

sudo systemctl restart isc-dhcp-server

|

DHCPv6

Dans l'implémentation DHCP de l'ISC, un même binaire assure le job pour IPv4 et pour IPv6 : un commutateur permet d'indiquer la version désirée. Aucun initscript n'est livré dans le paquet Debian pour démarrer un serveur DHCPv6. Voici notre initscript, librement adapté de l'initscript v4, qui contrairement à son homologue, n'inclu pas un fichier /etc/default/isc-dhcp6-server (aka tout est défini dans notre initscript) :

#!/bin/sh # # $Id: isc dhcp server.init.d,v 4.2.1-P1 2011/04/05 /usr/local/sbin/dhcpd$ # ### BEGIN INIT INFO # Provides: dhcpd6-server # Required-Start: $remote_fs $network $syslog # Required-Stop: $remote_fs $network $syslog # Should-Start: $local_fs slapd # Should-Stop: $local_fs slapd # Default-Start: 2 3 4 5 # Default-Stop: 1 # Short-Description: DHCP server # Description: Dynamic Host Configuration Protocol Server ### END INIT INFO PATH=/sbin:/bin:/usr/sbin:/usr/bin # config file NAME=dhcpdv6 DESC="DHCP IPv6 server" INTERFACES="" SERVER=/usr/sbin/dhcpd SERVERARGS="-6" CONFIGFILE=/etc/dhcp/dhcpd6.conf LIBFOLDER=/var/lib/dhcpv6 LEASEFILE="${LIBFOLDER}/dhcpdv6.leases" RUNFOLDER=/var/run/dhcpv6 DHCPDPID="${RUNFOLDER}/dhcpdv6.pid" # check filetypes/values test -f "${SERVER}" || exit 0 # include all init functions . /lib/lsb/init-functions test_config() { # 1.) check config if [ ! "${SERVER}" "${SERVERARGS}" -t -q -cf "${CONFIGFILE}" > /dev/null 2>&1 ]; then echo "${NAME} self-test failed. Please fix the config file." echo "The error was: " "${SERVER}" "${SERVERARGS}" -t -cf "${CONFIGFILE}" exit 1 fi # 2.) test_config will started if someone wants to start the server # test if the server is currently running if [ "${1}" = "start" ]; then if [ -e "${DHCPDPID}" ]; then stop_server "Currently running instance of ${DESC} found (PID: `cat ${DHCPDPID}`) - will now stop this instance" fi fi } stop_server(){ if [ "${1}" != "" ]; then log_daemon_msg "${1}" fi if [ -e "${DHCPDPID}" ]; then log_daemon_msg "Stopping ${DESC} ${NAME} [`cat ${DHCPDPID}`]" start-stop-daemon --stop --quiet --pidfile "${DHCPDPID}" log_end_msg $? rm -f "${DHCPDPID}" else log_daemon_msg "Stopping ${DESC} ${NAME}: nothing do do, no pidfile found" fi } # single arg is -v for messages, -q for none check_status(){ if [ ! -r "$DHCPDPID" ]; then test "$1" != -v || echo "$NAME is not running." return 3 fi if read pid < "$DHCPDPID" && ps -p "$pid" > /dev/null 2>&1; then test "$1" != -v || echo "$NAME is running." return 0 else test "$1" != -v || echo "$NAME is not running but $DHCPDPID exists." return 1 fi } case "$1" in start) test_config ${1} log_daemon_msg "Starting ${DESC} ${NAME}" # allow dhcp server to write lease and pid file if [ ! -e "${RUNFOLDER}" ]; then # create run folder mkdir -p "${RUNFOLDER}" #chown dhcpd:dhcpd "${RUNFOLDER}" # create pid file touch "${DHCPDPID}" #chown dhcpd:dhcpd "${DHCPDPID}" else # create pid file touch "${DHCPDPID}" #chown dhcpd:dhcpd "${DHCPDPID}" fi if [ ! -e "${LIBFOLDER}" ]; then # create run folder mkdir -p "${LIBFOLDER}" #chown dhcpd:dhcpd "${LIBFOLDER}" # create lease file touch "${LEASEFILE}" #chown dhcpd:dhcpd "${LEASEFILE}" else # create pid file touch "${LEASEFILE}" #chown dhcpd:dhcpd "${LEASEFILE}" fi start-stop-daemon --start --quiet --pidfile "${DHCPDPID}" \ --exec "${SERVER}" -- "${SERVERARGS}" -q $OPTIONS -cf "${CONFIGFILE}" -lf "${LEASEFILE}" -pf "$DHCPDPID" ${INTERFACES} sleep 2 if check_status -q; then log_end_msg 0 else log_failure_msg "check syslog for diagnostics." log_end_msg 1 exit 1 fi ;; stop) # stop dhcp server stop_server ;; restart | force-reload) test_config $0 stop sleep 2 $0 start if [ "$?" != "0" ]; then exit 1 fi ;; status) echo -n "Status of $DESC: " check_status -v exit "$?" ;; *) echo "Usage: $0 {start|stop|restart|force-reload|status}" exit 1 esac exit 0 |

Bon, en 2016, je pense qu'une unit systemd serait plus pertinente et prendrait moins de temps à être déployée, mais je vous livre quand même cet initscript : puisqu'il existe, autant qu'il serve.

On active ce service :

sudo chmod +x /etc/init.d/isc-dhcp6-server sudo systemctl daemon-reload sudo systemctl enable isc-dhcp6-server |

On pose la configuration dans le fichier /etc/dhcp/dhcpd6.conf :

# Enable RFC 5007 support (same than for DHCPv4)

allow leasequery;

# TESTAP

subnet6 2001:470:c8d6:2::/64

{

option dhcp6.name-servers 2a00:5881:8100:1000::3, 2a00:5884:8218::1;

option dhcp6.info-refresh-time 25200; # 7H

# range6 2001:470:c8d6:2::/64;

}

# TESTAP-sec

subnet6 2001:470:c8d6:3::/64

{

option dhcp6.name-servers 2a00:5881:8100:1000::3, 2a00:5884:8218::1;

option dhcp6.info-refresh-time 25200;

# range6 2001:470:c8d6:3::/64;

}

|

La configuration est répétitive, mais il nous faut obligatoirement de la config' dans les sections « subnet6 » sinon le serveur refuse de démarrer. Cette configuration sera simplifiée par la suite.

Si l'on active les options « range6 », notre serveur DHCPv6 répondra aux requêtes DHCPv6 d'attribution d'adresse. On serait alors dans une configuration stateful. Comme nous l'avons déjà écrit, ce n'est pas ce que nous voulons.

On démarre le serveur DHCPv6 :

sudo systemctl start isc-dhcp6-server

|

NAPT

On ajoute une règle de NAPT :

sudo iptables -t nat -A POSTROUTING -o eth0 -j ACCEPT |

Nous mettrons en place la persistance de cette configuration lorsque nous installerons PepperSpot.

Tester

On peut procéder à un premier test de notre installation en nous connectant à chacun de nos deux réseaux Wi-Fi. Pour chaque, on doit obtenir une IPv4 dans le bon réseau, une IPv6 dans le bon réseau, les adresses (v4 et v6) du routeur et les adresses (IPv4 et IPv6) de nos résolveurs DNS. On doit être en mesure d'utiliser pleinement Internet.

De plus, à la réception d'un message « Router Advertisement », notre machine doit émettre une requête DHCPv6 « Information-request » et notre serveur DHCPv6 doit répondre avec un message « Reply » contenant les adresses IPv6 de nos résolveurs DNS.

Si tout cela est OK, nous pouvons passer à la suite.

Authentification 802.1X

(Free)RADIUS

À propos de RADIUS, de FreeRADIUS, d'EAP, etc., je recommande les deux ressources suivantes : présentation de RADIUS, EAP et FreeRADIUS et formation vidéo RADIUS.

On installe l'implémentation RADIUS de référence, FreeRADIUS :

sudo apt-get install freeradius |

Par défaut, FreeRADIUS écoute uniquement en IPv4. Il faut corriger cela en ajoutant ce qui suit dans /etc/freeradius/radiusd.conf :

# Listen v6

# For authentication

listen {

type = auth

ipv6addr = ::1

port = 1812

}

# For accounting

listen {

type = acct

ipv6addr = ::1

port = 1813

}

|

Oui, on pourrait mettre « ipv6addr = * » mais, notre AP Cisco n'étant pas compatible IPv6, il n'y a que notre portail captif, installé sur la même machine, qui viendra faire des requêtes.

Dans /etc/freeradius/clients.conf, il faut ajouter les NAS qui seront autorisés à faire des requêtes auprès de notre serveur :

# localhostv6

client ::1 {

ipv6addr = ::1

secret = <secret_radius>

shortname = localhostv6

}

client ap {

ipaddr = 198.18.255.1

secret = <secret_radius>

}

|

Notons que quand le nom d'un client peut être résolu, il n'y a pas besoin de préciser « ipaddr ».

Il faut maintenant ajouter les utilisateurs autorisés à se connecter à notre base de données. Par défaut, FreeRADIUS utilise uniquement un fichier, /etc/freeradius/users. Exemple de ligne à ajouter :

guigui Cleartext-Password := "toor" |

Mais stocker les mots de passe en clair, ça tue des chatons. FreeRADIUS prend en charge quelques fonctions cryptographiques désuètes : NT, MD5, SHA-1, SHA-1 avec un sel et crypt (oui, la fonction anciennement utilisée pour stocker les mdps de session dans /etc/shadow, désormais on l'utilise avec un sel et des fonctions de hachage genre SHA2). On remarquera que tous ces algos sont morts : NT = MD4 = mort, MD5 = mort, crypt (version originale) = mort, SHA-1 et SHA-1 salé résistent encore au bruteforce quand elles sont utilisées avec de vrais mots de passe complexes donc c'est quasiment une illusion sur un hotspot (nous n'aurons pas de mdp complexes). La seule alternative viable serait de modifier les modules de FreeRADIUS ou d'utiliser pam plus des algos cryptos encore viable derrière…

Regardons malgré tout pour SHA1. Pour obtenir le hash d'un mdp de passe, on utilise la commande suivante :

echo -n "<mdp>" | sha1sum |

Exemple de ligne à ajouter dans le fichier users de freeRADIUS :

guigui SHA1-Password := "<hash>" |

On redémarre notre serveur RADIUS avec la nouvelle configuration :

sudo systemctl restart freeradius

|

On teste notre RADIUS :

radtest -6 <identifiant> <mdp> ::1 0 <secret_radius_pour_localhost> |

On doit forcément obtenir un « Accept-Accept » avant de passer à la suite.

802.1X sur un AP Cisco Aironet

Les lignes de commande KiVontBien pour activer l'authentification 802.1X sur notre SSID TESTAP-sec :

radius-server host 198.18.255.0 auth-port 1812 acct-port 1813 key 0 <secret_radius> aaa group server radius rad_eap server 198.18.255.0 auth-port 1812 acct-port 1813 aaa authentication identifiant eap_methods group rad_eap int Dot11Radio 0 encryption vlan 3 mode ciphers tkip dot11 ssid TESTAP-sec authentication open eap eap_methods authentication network-eap eap_methods authentication key-management wpa |

802.1X sur un AP WRT54GL avec OpenWRT

Documentation : Introduction to 802.1x sur le wiki OpenWRT.

Dans /etc/config/wireless, ajouter ce qui suit à notre SSID TESTAP-sec :

option encryption wpa2

option server 198.18.255.0

option key <secret_radius>

|

Puis :

/etc/init.d/network restart |

Note : dans la déclinaison brcm2.4 d'OpenWRT, le NAS est un soft privateur de Broadcom, nommé « nas » (imagination, quand tu nous tiens). Il va de pair avec le driver Wi-Fi privateur de Broadcom, wl. hostapd prend en charge uniquement le driver libre mac80211 qui ne prend pas en charge le chip Wi-FI du WRT54GL. hostapd fonctionne avec le driver libre b43 (qui est présent dans la déclinaison brcm47 d'OpenWRT) mais ce driver ne permet pas d'émettre plusieurs SSID en même temps.

Tester

À partir d'ici, il doit être possible de se connecter à notre réseau TESTAP-sec en utilisant l'authentification 802.1X. \o/

Pour vous connecter, votre gestionnaire réseau (GNOME Network Manager, par exemple) vous demandera le certificat x509 public de l'autorité de certification (AC) qui a signé le certificat de votre AP afin de valider ce dernier. Par défaut, sous Debian, freeRADIUS utilise un certificat bidon autosigné généré automatiquement lors de l'installation. Il se trouve dans /etc/freeradius/certs/server.pem et c'est lui qu'il faudra utiliser. Hé, oui, en EAP-TTLS, chaque client discute avec le RADIUS : les messages EAP sont encapsulés dans des messages RADIUS par le NAS qui fait partie intégrante du point d'accès Wi-Fi. Dans le sens inverse, le NAS relaie aussi les challenges cryptographiques envoyés par le serveur RADIUS au client afin que ce dernier les résolve afin de prouver son identité.

Attention avec OpenWRT : le NAS de Broadcom est très chatouilleux : un acces-reject et votre machine cliente est bloquée (probablement en utilisant la MAC). J'ai attendu plusieurs heures, pas de déblocage, seul un « /etc/init.d/network restart » permet de redonner une chance à la machine cliente. En revanche, on peut se déconnecter/reconnecter du réseau autant de fois que l'on veut si le RADIUS retourne un « access-accept ». Comportement incompréhensible. :-

Stocker les utilisateurs de notre hotspot dans MySQL

On installe le nécessaire :

sudo apt-get install freeradius-mysql mysql-server |

On crée la base de données pour freeRADIUS, on crée un utilisateur radius dédié, on crée un premier utilisateur de notre hotspot :

sudo mysql -u root -p mysql> CREATE DATABASE radius; mysql> GRANT ALL PRIVILEGES ON radius.* TO radius@localhost IDENTIFIED BY "<mdp>"; mysql> flush privileges; mysql> source /etc/freeradius/sql/mysql/schema.sql mysql> insert into radcheck VALUES (1, 'guigui', 'SHA1-Password', ':=', '<hash_mdp>'); mysql> exit |

On utilise « sudo » afin que MySQL puisse lire le fichier /etc/freeradius/sql/mysql/schema.sql . 😉 On ne restreint pas cet utilisateur en lecture seule car daloRADIUS utilisera ce compte pour écrire dans la base de données RADIUS.

Il faut activer le module SQL dans freeRADIUS : dans /etc/freeradius/radiusd.conf, « $INCLUDE sql.conf » ne doit plus être en commentaire. Dans /etc/freeradius/sql.conf, il faut changer le mot de passe permettant de se connecter à la base de données.

Il faut indiquer à freeRADIUS d'utiliser le module SQL pour réaliser l'autorisation, c'est-à-dire remonter les informations que l'on a sur un utilisateur depuis la BDD. Pour cela, il faut décommenter « sql » dans la section « authorize » de /etc/freeradius/sites-enabled/inner-tunnel pour l'authentification 802.1X (car notre serveur RADIUS connaît le mot de passe de l'utilisateur uniquement quand le tunnel EAP-TTLS a été établi) et dans la section « authorize » du fichier /etc/freeradius/sites-enabled/default pour le portail captif puisque celui-ci n'utilise pas de tunnel.

On met en commentaire notre tout premier utilisateur de test dans /etc/freeradius/users.

On teste qu'il est toujours possible de nous authentifier sur notre SSID TESTAP-sec.

Alléger et sécuriser freeRADIUS

Si l'on est sûr que notre RADIUS ne servira pas à faire autre chose que de l'authentification au-dessus d'EAP, alors on peut mettre en commentaire chap, mschap, digest et pap dans la section « authorize » de /etc/freeradius/sites-enabled/default. Le seul module dont nous ayons besoin ici est eap. Pour le portail captif, le module « sql » ou le module « files » positionnera un attribut « Auth-Type := PAP » qui activera le bon module dans la section « authenticate ». On peut également mettre en commentaire « preprocess » et « suffix », nous n'en avons pas besoin ici (nous n'utilisons pas de huntgroup ni de realm).

On peut également alléger la configuration du module eap dans /etc/freeradius/eap.conf. On peut mettre en commentaire md5 (aka eap-md5), leap (aka eap-leap), peap et mschapv2 dans la section « authorize ». On peut également changer la valeur de « default_eap_type » pour la passer de « md5 » à « ttls ». Notons qu'il n'est pas possible de changer la valeur du même « default_eap_type » dans le module ttls.

On peut également alléger la configuration qui s'applique à tout tunnel EAP établi. C'est dans /etc/freeradius/sites-enabled/inner-tunnel que cela se passe. On peut mettre en commentaire mschap, eap et suffix. On notera là aussi que les modules files et sql autorisent obligatoirement et forcément l'usage de CHAP (et PAP) pour l'authentification à l'intérieur du tunnel. On ne peut pas désactiver ce comportement, même en mettant en commentaire toute référence à CHAP/MSCHAP dans tous les fichiers de freeRADIUS.

Puisque nous utilisons TTLS, donc un tunnel TLS, toutes les recommandations applicables à TLS s'appliquent ici aussi :

- Il faut utiliser autre chose qu'un certificat x509 qui n'est pas à votre nom. De plus, utiliser autre chose qu'un certificat auto-signé permet d'en changer régulièrement sans devoir le diffuser à tous les utilisateurs de votre réseau sans fil (diffuser le certificat de l'autorité de certification (AC) suffit). Quant à savoir s'il faut utiliser une AC publique reconnue ou une AC privée interne à votre organisation pour signer le certificat de votre serveur RADIUS, la problématique qui se pose est la même qu'avec OpenVPN : utiliser une AC publique vous expose à un point d'accès malveillant portant le même nom (les machines de vos clients Wi-Fi s'y connecteront donc automatiquement, sans rien demander à leur utilisateur car le standard Wi-Fi est ainsi fait) et qui utilisera un certificat x509 parfaitement légitime obtenu auprès de la même AC publique que vous pour voler les mots de passe, savoir qui est connecté au réseau, etc.

- Il faudrait normalement utiliser TLS v1.2 ainsi que des suites cryptographiques pas complètement moisies, comme dans tout usage de TLS. Sauf que la compatibilité avec les clients est loin d'être garantie. Illustration : GNOME Network Manager dans Debian Jessie, qui se repose sur wpa_supplicant, utilise uniquement TLS v1.0… Pour changer les suites cryptographiques autorisées, il faut modifier la valeur de « cipher_list » dans /etc/freeradius/eap.conf et ça mange une chaîne habituelle dans le monde TLS.

Pro-tips : j'imagine que vous allez vouloir tester cette nouvelle configuration. GNOME network-manager est parfois long à la détente quand on change le mode d'authentification. Ce qui fait qu'on a choisi « MD5 » (alors qu'on utilisait PAP avant, par exemple) et que l'on constate que l'authentification fonctionne. Ce n'est pas que freeRADIUS a accepté du EAP-MD5 (qu'on vient de désactiver) mais simplement que GNOME Network Manager a bien utilisé du EAP-PAP. Il faut réessayer et là, l'authentification échouera. Mon conseil est de lancer freeradius en mode debug avec la commande « freeradius -X ». Comme cela, on voit très précisément les modules qui ont été utilisés et les résultats produits.

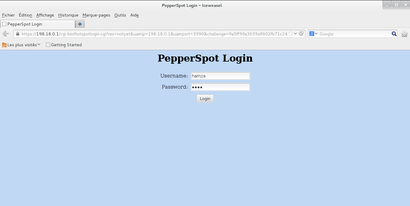

PepperSpot

Faire le ménage

PepperSpot s'occupe de l'adressage de son interface réseau de travail et de fournir un serveur DHCPv4. Il faut donc mettre en commentaire notre configuration applicable à TESTAP dans /etc/dhcp/dhcpd.conf et redémarrer le serveur DHCPv4. Même chose pour DHCPv6 qui ne pourra pas se binder sur l'interface tun crée par PepperSpot comme nous l'avons déjà exposé. De même, le fichier /etc/network/interfaces doit désormais ressembler à ça pour notre interface testap (le reste est inchangé) :

# TESTAP auto testap iface testap inet manual post-up ip link add link eth0 name $IFACE type vlan id 2 2> /dev/null || true post-up ip link set $IFACE up iface testap inet6 manual |

Lire le manuel

Le fichier README de PepperSpot est plutôt complet. Après toute la configuration qu'on a déjà abattu, les sections encore pertinentes sont la 3 sur la configuration du serveur web pour servir la page d'auth, la 1,3 et 1,4 sur les dépendances nécessaires à la compilation de PepperSpot, la 5 sur la compilation, l'installation et la configuration ainsi que la 6 sur le lancement du portail captif.

Je vais formuler quelques remarques complémentaires ci-dessous.

Remarque sur l'IPv6 forwarding et l'autoconfiguration IPv6 (section 1.1.3)

Avec Linux, il est parfaitement possible d'être un routeur et d'accepter des messages RA sur certaines interfaces pour s'autoconfigurer. Pour ce faire, il faut donner la valeur « 2 » à « net.ipv6.conf.all.forwarding » dans sysctl.conf. Pas besoin de Quagga ni du protocole de routage RIP.

Remarques sur le serveur web

La version PHP du portail captif fonctionne très bien out-of-box dès lors que l'on a installé libapache2-mod-php5, ce qui est logique.

Pour la version CGI, il faut activer CGI :

sudo a2enmod cgi && sudo systemctl reload apache2 |

Notons que le script n'est pas prévu pour être exécuté par fcgid car il provoque l'affichage du portail captif dans les logs d'Apache et, car la variable d'environnement « HTTPS » (qui indique si l'URL demandée contient « https ») n'est pas définie par fcgid, ce qui ne convient pas à PepperSpot.

Dans tous les cas, depuis Apache 2.4, il convient de remplacer les lignes « Order [...] » par « Require all granted ». De même, le fichier représentant le virtualhost doit avoir une extension « .conf » afin qu'il soit pris en considération par Apache.

Remarques sur les règles de filtrage

Dans pepper.iptables, en plus d'effectuer la modification des variables $EXTIF4 et $INTIF4, nous modifions la règle « $IPTABLES -A INPUT -i $EXTIF4 -j REJECT » pour remplacer le REJECT par un DROP. Ensuite, nous autorisons notre AP Cisco à causer avec notre serveur RADIUS (à mettre avant la règle précédemment modifiée) :

$IPTABLES -A INPUT -i $EXTIF -s 198.18.255.1 -d 198.18.255.0 -p udp -m multiport --dports 1812,1813 -m state --state NEW -j ACCEPT |

Nous décommentons également la règle « Allow ICMP echo on other interfaces (input) », car c'est toujours utile pour debug.

Enfin, avant « Drop everything to and from $INTIF (forward) », on ajoute les règles suivantes pour empêcher tout trafic entre nos clients Wi-Fi et le réseau de management :

$IPTABLES -A FORWARD -i testap -d 198.18.255.0/31 -j DROP $IPTABLES -A FORWARD -i tun0 -d 198.18.255.0/31 -j DROP $IPTABLES -A FORWARD -i tapsec -d 198.18.255.0/31 -j DROP |

Et l'on ajoute les règles suivantes pour éviter tout trafic entre nos deux réseaux Wi-Fi :

$IPTABLES -A FORWARD -i testap -o tapsec -j DROP $IPTABLES -A FORWARD -i tun0 -o tapsec -j DROP $IPTABLES -A FORWARD -i tapsec -o testap -j DROP $IPTABLES -A FORWARD -i tapsec -o tun0 -j DROP |

Pour faire propre, on peut créer des variables au début du script pour stocker tapsec, tun0 & co mais on va voir que le but de ce script est de servir de rares fois. 🙂

Dans pepper.ip6tables, en plus d'effectuer la modification des variables $EXTIF4 et $INTIF4, nous mettons en commentaire la règle qui autorise RIPng. Nous modifions également la règle « $IP6TABLES -A INPUT -i $EXTIF6 -j REJECT » pour remplacer le REJECT par un DROP.

Nous ajoutons une règle pour autoriser DHCPv6 depuis l'intérieur et ping6 depuis partout (avant « Allow everything on loopback ») :

$IP6TABLES -A INPUT -i tapsec -p udp --sport 546 --dport 547 -j ACCEPT $IP6TABLES -A INPUT -p icmpv6 --icmpv6-type echo-request -j ACCEPT |

Avant « Drop everything to and from $INTIF (forward) », nous ajoutons les règles suivantes pour bloquer tout trafic entre nos deux réseaux Wi-Fi :

$IP6TABLES -t filter -A FORWARD -i testap -o tapsec -j DROP $IP6TABLES -t filter -A FORWARD -i tun1 -o tapsec -j DROP $IP6TABLES -t filter -A FORWARD -i tapsec -o testap -j DROP $IP6TABLES -t filter -A FORWARD -i tapsec -o tun1 -j DROP |

Note : fermer le port 3990 est une mauvaise idée : PepperSpot utilise ce port pour communiquer avec lui-même pour l'authentification.

Pour rendre ces règles de filtrage persistantes, nous utilisons netfilter-persistent. D'abord, on ajoute les règles à Netfilter en exécutant les scripts pepper.iptables et pepper.ip6tables. Ensuite, on installe netfilter-persistent :

sudo apt-get install netfilter-persistent iptables-persistent |

Lors de l'installation, il sera demandé s'il faut conserver les règles de filtrage existantes. Il faudra acquiser. Les règles de filtrage (et de NAPT) seront restaurées à chaque boot de la passerelle.

Remarque sur la configuration

Voici notre fichier /etc/pepper.conf une fois les lignes vides ou commentées retirées :

ipversion dual net 198.18.0.0/24 staticipv6 2001:470:c8d6:2::1 ipv6prefix 2001:470:c8d6:2::/64 dns1 89.234.141.66 dns2 89.234.186.18 radiusserver1 ::1 radiusserver2 127.0.0.1 radiussecret <secret_radius> radiuslocationid isocc=fr,cc=33,ac=67000,network=portail_ipv6 dhcpif testap uamserver https://198.18.0.1/cgi-bin/hotspotidentifiant.cgi uamserver6 https://[2001:470:c8d6:2::1]/cgi-bin/hotspotidentifiant.cgi uamsecret testing234 |

Remarques sur le lancement automatique

Dans un premier temps, on peut lancer PepperSpot en premier plan pour voir si la config' est OK :

sudo pepper -fd |

Un bout d'initscript est présent dans le dossier « debian » des sources, mais une unit systemd nous a paru plus adaptée (nous la stockons dans /etc/systemd/system/pepperspot.service) :

[Unit] Description=Pepperspot After=syslog.target network.target netfilter-persistent.service [Service] Type=simple ExecStart=/usr/sbin/pepper [Install] WantedBy=multi-user.target |

On active ce service et on le lance :

sudo systemctl enable pepperspot sudo systemctl start pepperspot |

Données de connexion

Accounting RADIUS

Sur un point d'accès Cisco Aironet 1120B

Pour activer l'accounting RADIUS, il faut utiliser les commandes suivantes :

aaa accounting network acct_methods start-stop group rad_eap dot11 ssid TESTAP-sec accounting acct_methods |

Pour rappel : l'AP n'envoie pas les adresses IP du client dans les requêtes d'accounting. L'attribut RADIUS correspondant, « Framed-IP-Address » peut seulement être ajouté aux requêtes de demande d'accès en utilisant la commande « radius-server attribute 8 include-in-access-req ».

Sur un point d'accès WRT54GL avec OpenWRT

Le NAS privateur de Broadcom ne prend pas en charge l'accounting RADIUS. hostapd le fait, mais nous avons vu qu'il n'est pas utilisable avec notre WRT54GL.

Actualisation fréquente…